قانون هوش مصنوعي اتحاديه اروپا

قانون هوش مصنوعی اتحادیه اروپا

معرفی:

قانون هوش مصنوعی اتحادیه اروپا (AI Act) که در ۱۳ ژوئن ۲۰۲۴ تصویب شد، به منظور تنظیم استفاده از سیستمهای هوش مصنوعی و تعادل بین نوآوری و حقوق شهروندان طراحی شده است.

١. رويكرد مبتني بر ريسك:

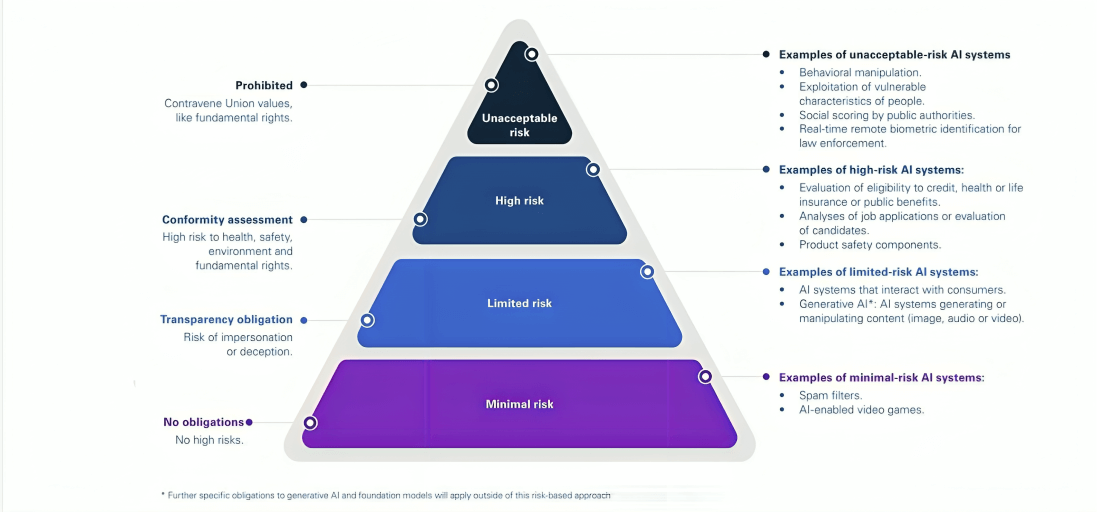

سیستمهای هوش مصنوعی بر اساس سطح ریسک به چهار دسته تقسیم میشوند: غیرقابل قبول (ممنوع)، بالا، محدود و حداقل.

٢. ممنوعيت ها:

برخی کاربردهای هوش مصنوعی، مانند سیستمهای امتیازدهی اجتماعی و نظارت بیومتریک، ممنوع شدهاند تا از نقض حقوق شهروندان جلوگیری شود.

٣. الزامات براي سيستمهاي پرخطر:

این سیستمها باید الزامات دقیقی در زمینه کیفیت داده، مستندسازی، شفافیت و نظارت انسانی رعایت کنند.

٤. تعهدات شفافيت:

تمام سیستمهای هوش مصنوعی باید به کاربران اطلاع دهند که با یک سیستم هوش مصنوعی در تعامل هستند.

٥. مقررات براي مدل هاي عمومي:

مدلهای هوش مصنوعی عمومی باید تحت مقررات خاصی برای مدیریت ریسکها قرار گیرند.

٦. ساختار حاكميتي:

هیئت اروپایی، دفتر هوش مصنوعی اروپا و مقامات ملی نظارت و اجرای مؤثر قانون را تضمین میکنند.

٧. سندباكسهاي نظارتي:

فضاهای آزمایشی تحت نظارت به شرکتها اجازه میدهند تا فناوریهای جدید را بدون ریسکهای قانونی آزمایش کنند.

٨. حمايت از SME ها و استارتاپ ها:

مقررات خاص برای حمایت از شرکتهای کوچک و متوسط و استارتاپها وجود دارد.

٩. تمركز بر حقوق اساسي:

قانون بر حفاظت از حقوق اساسی، از جمله حریم خصوصی، عدم تبعیض و کرامت انسانی تأکید دارد.

١٠. مكانيسم هاي اجرا و جريمه:

جریمههای سنگین برای نقض قانون تا ۳۵ میلیون یورو یا ۷٪ از گردش مالی جهانی تعیین شده است.

١١. بازنگري و به روزرساني منظم:

قانون شامل مکانیسمهایی برای بازنگری و بهروزرسانی منظم با پیشرفتهای فناوری است.

١٢. تعامل با ساير قوانين اتحاديه اروپا:

قانون با GDPR و قوانین خدمات دیجیتال هماهنگ شده است.

١٣. توجه به پايداري زيست محيطي:

ترویج سیستمهای سازگار با محیط زیست بخشی از قانون است.

١٤. حمايت از حقوق كارگران:

مقررات خاصی برای استفاده از هوش مصنوعی در محیط کار وجود دارد.

١٥. همكاري بين المللي:

قانون بر همکاری با شرکای بینالمللی برای ایجاد استانداردهای جهانی هوش مصنوعی تأکید دارد.

تاریخچه قانون

تاریخچه شکلگیری و اهداف قانون هوش مصنوعی اتحادیه اروپا

۱. پیشزمینه (۲۰۱۸-۲۰۱۹):

- در آوریل ۲۰۱۸، کمیسیون اروپا استراتژی هوش مصنوعی برای اروپا را منتشر کرد.

- در دسامبر ۲۰۱۸، کمیسیون طرح هماهنگ برای هوش مصنوعی را ارائه داد.

- در آوریل ۲۰۱۹، گروه کارشناسان سطح بالای هوش مصنوعی، دستورالعملهای اخلاقی برای هوش مصنوعی قابل اعتماد را منتشر کرد.

۲. کتاب سفید هوش مصنوعی (فوریه ۲۰۲۰):

- کمیسیون اروپا کتاب سفیدی درباره هوش مصنوعی منتشر کرد که چارچوب سیاستی برای توسعه هوش مصنوعی در اروپا را ترسیم میکرد.

- این سند، رویکردی مبتنی بر مدیریت ریسک را برای تنظیم قوانین در حوزه هوش مصنوعی پیشنهاد کرد.

۳. مشاوره عمومی (۲۰۲۰):

- کمیسیون اروپا مشاوره عمومی گستردهای درباره کتاب سفید انجام داد که بیش از ۱۲۰۰ پاسخ دریافت کرد.

۴. قطعنامه پارلمان اروپا (اکتبر ۲۰۲۰):

- پارلمان اروپا قطعنامهای را تصویب کرد که خواستار تدوین چارچوب قانونی برای جنبههای اخلاقی هوش مصنوعی بود.

۵. پیشنهاد اولیه قانون (آوریل ۲۰۲۱):

- کمیسیون اروپا پیشنهاد اولیه برای قانون هوش مصنوعی را منتشر کرد.

۶. مذاکرات و اصلاحات (۲۰۲۱-۲۰۲۳):

- پارلمان اروپا و شورای اتحادیه اروپا پیشنهاد را بررسی و اصلاح کردند.

- گروههای مختلف ذینفع، از جمله صنعت، دانشگاهیان و جامعه مدنی نظرات خود را ارائه دادند.

۷. مذاکرات سهجانبه (۲۰۲۳):

- نمایندگان پارلمان، شورا و کمیسیون مذاکرات فشردهای برای رسیدن به توافق نهایی انجام دادند.

۸. توافق سیاسی (دسامبر ۲۰۲۳):

- در ۸ دسامبر ۲۰۲۳، یک توافق سیاسی موقت بر سر متن نهایی قانون حاصل شد.

۹. تصویب نهایی (۲۰۲۴):

- پارلمان اروپا و شورا متن نهایی را تصویب کردند.

- قانون در ۱۳ ژوئن ۲۰۲۴ امضا و نهایی شد.

اهداف اصلی قانون هوش مصنوعی اتحادیه اروپا

۱. بهبود عملکرد بازار داخلی:

- ایجاد یک چارچوب قانونی یکپارچه برای توسعه، بازاریابی، و استفاده از سیستمهای هوش مصنوعی در اتحادیه اروپا.

۲. ترویج هوش مصنوعی انسانمحور و قابل اعتماد:

- اطمینان از اینکه سیستمهای هوش مصنوعی به ارزشها و حقوق اساسی اتحادیه اروپا احترام میگذارند.

۳. حفاظت از سلامت، ایمنی و حقوق اساسی:

- جلوگیری از آسیبهای بالقوه سیستمهای هوش مصنوعی به شهروندان و جامعه.

۴. حمایت از نوآوری:

- ایجاد محیطی قانونی که نوآوری در هوش مصنوعی را تشویق میکند، به ویژه برای شرکتهای کوچک و متوسط (SMEها) و استارتاپها.

۵. افزایش اعتماد به هوش مصنوعی:

- ایجاد اطمینان برای کاربران و مصرفکنندگان که سیستمهای هوش مصنوعی ایمن و قابل اعتماد هستند.

۶. هماهنگ سازی قوانین در سراسر اتحادیه اروپا:

- جلوگیری از تکهتکه شدن بازار داخلی با قوانین ملی متفاوت.

٧. تقويت رقابت پذيري جهاني:

•تبدیل اتحادیه اروپا به رهبر جهانی در توسعه هوش مصنوعی اخلاقی و قابل اعتماد.

۸. حفاظت از محیط زیست:

- تشویق توسعه سیستمهای هوش مصنوعی که به اهداف زیستمحیطی کمک میکنند.

۹. ایجاد شفافیت و پاسخگویی:

- اطمینان از اینکه استفاده از سیستمهای هوش مصنوعی شفاف است و توسعهدهندگان و کاربران آنها پاسخگو هستند.

۱۰. حمایت از دموکراسی و حاکمیت قانون:

– محافظت از فرآیندهای دموکراتیک و سیستمهای قضایی در برابر دستکاری یا سوءاستفاده از هوش مصنوعی.

۱۱. تمرکز بر سواد هوش مصنوعی:

– تاکید بر اهمیت افزایش سواد هوش مصنوعی در میان ارائهدهندگان، کاربران و عموم مردم. دفتر هوش مصنوعی اروپا وظیفه ترویج ابزارهای آگاهیرسانی عمومی را بر عهده دارد.

۱۲. توجه به گروههای آسیب پذیر:

– تاکید ویژه بر حفاظت از گروههای آسیبپذیر، از جمله کودکان و افراد دارای معلولیت، در برابر خطرات هوش مصنوعی.

۱۳. همکاری بینالمللی:

– تاکید بر اهمیت همکاری با شرکای بینالمللی در زمینه استانداردهای هوش مصنوعی و تلاش برای ایجاد همگرایی جهانی در رویکردهای نظارتی.

۱۴. تأکید بر حقوق کارگران:

– شامل مقرراتی برای حفاظت از حقوق کارگران در استفاده از سیستمهای هوش مصنوعی در محل کار.

۱۵. مقررات خاص برای بخش مالی:

– تعیین مقررات ویژه برای استفاده از هوش مصنوعی در بخش خدمات مالی.

۱۶. تعامل با سایر قوانین اتحادیه اروپا:

– توجه به تعامل با سایر قوانین اتحادیه اروپا، مانند قانون خدمات دیجیتال و مقررات حفاظت از دادهها.

۱۷. تأکید بر طراحی فراگیر:

– تاکید بر اهمیت طراحی فراگیر سیستمهای هوش مصنوعی، از جمله در نظر گرفتن نیازهای افراد دارای معلولیت.

۱۸. توجه به پایداری زیستمحیطی:

– شامل مقرراتی برای ترویج توسعه مدلهای هوش مصنوعی کارآمد در مصرف انرژی.

۱۹. حق توضیح:

– تضمین حق دریافت توضیح برای افراد تحت تأثیر تصمیمات گرفته شده توسط سیستمهای هوش مصنوعی پرخطر.

۲۰. مقررات مربوط به آزمایش در شرایط واقعی:

– ایجاد چارچوبی برای آزمایش سیستمهای هوش مصنوعی در شرایط واقعی قبل از ورود به بازار.

این قانون یک رویکرد جامع و چندبعدی به تنظیم هوش مصنوعی دارد که نه تنها جنبههای فنی، بلکه ابعاد اجتماعی، اخلاقی و زیستمحیطی را نیز در بر میگیرد.

ساختار و مطالب کلی قانون هوش مصنوعی اتحادیه اروپا

۱.تعریف سیستم هوش مصنوعی:

- قانون تعریفی گسترده از سیستمهای هوش مصنوعی ارائه میدهد که شامل ماشینهایی است که برای اهداف صریح یا ضمنی طراحی شدهاند و میتوانند خروجیهایی مانند پیشبینی، توصیه یا تصمیمات تولید کنند.

۲.طبقه بندی ریسک:

سیستمهای هوش مصنوعی به چند دسته تقسیم میشوند:- سیستمهای ممنوعه

- سیستمهای پرخطر

- سیستمهای کمخطر

- سیستمهای با ریسک حداقل

- قانون تعریفی گسترده از سیستمهای هوش مصنوعی ارائه میدهد که شامل ماشینهایی است که برای اهداف صریح یا ضمنی طراحی شدهاند و میتوانند خروجیهایی مانند پیشبینی، توصیه یا تصمیمات تولید کنند.

۳. سیستمهای هوش مصنوعی ممنوعه:

برخی کاربردهای هوش مصنوعی بهطور کامل ممنوع شدهاند، از جمله:

- سیستمهای دستکاری رفتار:

سیستمهایی که میتوانند آسیب قابل توجهی به افراد وارد کنند. - سیستمهای امتیازدهی اجتماعی:

استفاده از این سیستمها توسط مقامات دولتی برای ارزیابی و کنترل رفتار شهروندان ممنوع است.

- استفاده از سیستمهای تشخیص بیومتریک از راه دور در فضاهای عمومی برای اجرای قانون:

این ممنوعیت با برخی استثنائات محدود اعمال میشود.

۴. الزامات برای سیستمهای هوش مصنوعی پرخطر:

سیستمهای پرخطر باید الزامات سختگیرانهای را رعایت کنند، از جمله:

- سیستم مدیریت ریسک:

استفاده از فرآیندهای جامع مدیریت ریسک.

- کیفیت بالای مجموعه دادهها:

استفاده از دادههای دقیق و معتبر.

- مستندسازی فنی و ثبت وقایع:

تهیه مستندات کامل و ثبت تمامی رویدادها و اقدامات. - شفافیت و ارائه اطلاعات به کاربران:

اطلاعرسانی کافی به کاربران درباره نحوه کار سیستم.

- نظارت انسانی:

نظارت مستمر انسان بر عملکرد سیستم.

- دقت، استحکام و امنیت سایبری:

تضمین دقت و پایداری سیستمها و حفاظت از آنها در برابر تهدیدات سایبری.

۵. تعهدات شفافیت:

برخی سیستمهای هوش مصنوعی ملزم به اطلاعرسانی به کاربران هستند که آنها با یک سیستم هوش مصنوعی در تعامل هستند.

۶. مقررات برای مدلهای هوش مصنوعی عمومی:

الزامات خاصی برای ارائهدهندگان مدلهای هوش مصنوعی عمومی وضع شده است، به ویژه برای مدلهایی که دارای ریسک سیستمی هستند.

۷. ساختار حاکمیتی:

- تأسیس هیئت اروپایی هوش مصنوعی: نظارت بر اجرای قوانین و ارائه راهنماییهای لازم.

- تعیین مقامات ملی صلاحیتدار در هر کشور عضو: مسئولیت نظارت بر اجرای قوانین در هر کشور عضو اتحادیه.

- ایجاد دفتر هوش مصنوعی اروپا: هماهنگی و نظارت بر اجرای سیاستهای هوش مصنوعی در سطح اتحادیه.

۸. جریمهها:

جریمههای سنگینی برای نقض این مقررات در نظر گرفته شده است، از جمله:

- تا ۳۵ میلیون یورو یا ۷٪ از گردش مالی جهانی برای نقض ممنوعیتها.

- تا ۱۵ میلیون یورو یا ۳٪ از گردش مالی جهانی برای نقض سایر الزامات.

۹. زمانبندی اجرا:

- اکثر مفاد این قانون از ۲ آگوست ۲۰۲۶ اجرایی میشوند.

- بخشهایی مانند ممنوعیتها از ۲ فوریه ۲۰۲۵ اعمال میشوند.

۱۰. بازنگری و بهروزرسانی:

این قانون شامل مکانیزمهایی برای بازنگری و بهروزرسانی منظم است تا با پیشرفتهای فناوری همگام باشد.

این قانون رویکردی جامع و چندلایه برای تنظیم هوش مصنوعی در اتحادیه اروپا ارائه میدهد و تلاش میکند تعادلی میان ترویج نوآوری و حفاظت از حقوق و ایمنی شهروندان برقرار کند.

جزئیات طبقهبندی ریسک در قانون هوش مصنوعی اتحادیه اروپا

۱. سیستمهای هوش مصنوعی ممنوعه:

این سیستمها به دلیل ریسک غیرقابل قبول برای حقوق اساسی و امنیت شهروندان بهطور کامل ممنوع شدهاند. نمونههایی از این سیستمها عبارتند از:

- سیستمهای دستکاری رفتار:

سیستمی که قادر به وارد کردن آسیبهای قابل توجه به افراد است.

- سیستمهای امتیازدهی اجتماعی:

استفاده از این سیستمها توسط مقامات دولتی برای ارزیابی و نظارت بر رفتار شهروندان.

- سیستمهای تشخیص بیومتریک از راه دور در فضاهای عمومی برای اجرای قانون:

این ممنوعیت شامل استثنائات محدودی میشود.

- سیستمهای طبقهبندی بیومتریک بر اساس ویژگیهای حساس:

مانند نژاد، عقاید سیاسی، یا گرایش جنسی.

۲. سیستمهای هوش مصنوعی پرخطر:

این سیستمها ریسک بالایی برای سلامت، ایمنی، یا حقوق اساسی دارند، اما با رعایت الزامات سختگیرانه مجاز به استفاده هستند. این سیستمها به دو دسته اصلی تقسیم میشوند:

- سیستمهای ایمنی محصولات:

تحت قوانین هماهنگسازی اتحادیه اروپا، از جمله تجهیزات پزشکی، اسباببازیها، و خودروها.

- سیستمهای مستقل در حوزههای خاص

که در ضمیمه III قانون ذکر شدهاند، از جمله:

- سیستمهای بیومتریک:

شامل شناسایی و تایید هویت با استفاده از ویژگیهای بیومتریک.

- مدیریت زیرساختهای حیاتی:

نظارت و کنترل زیرساختهای کلیدی و ضروری.

- آموزش و تحصیلات:

استفاده از سیستمهای هوش مصنوعی در فرآیندهای آموزشی و تحصیلی.

- استخدام و مدیریت کارکنان:

سیستمهای مربوط به انتخاب و مدیریت نیروی کار.

- دسترسی به خدمات ضروری:

شامل خدمات خصوصی و عمومی که به بهبود کیفیت زندگی کمک میکنند.

- اجرای قانون:

استفاده از سیستمهای هوش مصنوعی در فرآیندهای اجرای قانون و نظارت.

- مدیریت مهاجرت، پناهندگی و کنترل مرزی:

استفاده از فناوریهای هوش مصنوعی در مدیریت و کنترل مهاجرت و پناهندگی.

- اجرای عدالت و فرآیندهای دموکراتیک:

استفاده از سیستمهای هوش مصنوعی در سیستم قضایی و فرآیندهای دموکراتیک.

- سیستمهای بیومتریک:

۳. سیستمهای هوش مصنوعی با ریسک محدود:

این سیستمها ملزم به رعایت الزامات شفافیت هستند. نمونههایی از این سیستمها عبارتند از:

- چتباتها:

سیستمهای هوش مصنوعی که برای تعامل با کاربران بهصورت متنی طراحی شدهاند. - سیستمهای تشخیص احساسات:

فناوریهایی که به شناسایی و تحلیل احساسات افراد میپردازند. - سیستمهای تولید یا دستکاری تصویر، صدا یا ویدئو:

مانند دیپفیکها که قادر به تولید یا تغییر محتوای چندرسانهای هستند.

۴. سیستمهای هوش مصنوعی با ریسک حداقل:

این سیستمها ریسک ناچیزی برای حقوق یا ایمنی شهروندان دارند و از الزامات خاصی معاف هستند. نمونههایی از این سیستمها عبارتند از:

- فیلترهای اسپم ایمیل:

سیستمهای هوش مصنوعی که به شناسایی و فیلتر کردن ایمیلهای ناخواسته کمک میکنند. - بازیهای ویدئویی مبتنی بر هوش مصنوعی:

بازیهایی که از فناوری هوش مصنوعی برای بهبود تجربه کاربری استفاده میکنند. - سیستمهای پیشنهاد فیلم یا موسیقی:

الگوریتمهای هوش مصنوعی که به پیشنهاد محتواهای مربوطه بر اساس ترجیحات کاربر میپردازند.

۵. مدلهای هوش مصنوعی عمومی:

این مدلها میتوانند برای طیف وسیعی از کاربردها استفاده شوند و تابع الزامات خاصی هستند، به ویژه اگر دارای “ریسک سیستمی” باشند، مانند مدلهای زبانی بزرگ. این الزامات به منظور کنترل و نظارت بر استفاده از مدلهایی که ممکن است تأثیرات گستردهتری داشته باشند، وضع شدهاند.

این طبقهبندی یک رویکرد متناسب با ریسک را ارائه میدهد، بهطوریکه سطح نظارت و الزامات با سطح ریسک بالقوه سیستمهای هوش مصنوعی افزایش مییابد. هدف این است که همزمان با محافظت از حقوق و ایمنی شهروندان، فضای لازم برای نوآوری در فناوری هوش مصنوعی فراهم شود.

مقررات مربوط به مدل های هوش مصنوعی عمومی در اتحادیه اروپا

۱. تعریف مدل هوش مصنوعی عمومی:

مدلهای هوش مصنوعی عمومی به آن دسته از مدلهایی اطلاق میشود که قابلیت انعطافپذیری بالا دارند و میتوانند طیف گستردهای از وظایف مختلف را انجام دهند. این مدلها معمولاً با مقادیر زیادی داده آموزش دیدهاند و قابلیت کاربرد در حوزههای متنوع را دارند.

۲. الزامات پایه برای تمام ارائهدهندگان مدلهای هوش مصنوعی عمومی:

تمام ارائهدهندگان مدلهای هوش مصنوعی عمومی ملزم به رعایت الزامات زیر هستند:

- تهیه و بهروزرسانی مستندات فنی:

شامل اطلاعات دقیق درباره فرآیند توسعه و آزمایش مدل. - ارائه اطلاعات و مستندات:

به ارائهدهندگان سیستمهای هوش مصنوعی که قصد دارند مدل را ادغام کنند. - ایجاد سیاستهای کپی رایت:

برای رعایت قوانین کپیرایت اتحادیه اروپا.

- انتشار عمومی خلاصهای از محتوای آموزشی:

بهمنظور شفافیت در مورد دادههای مورد استفاده برای آموزش مدل.

۳. مدلهای هوش مصنوعی عمومی با ریسک سیستمی:

مدلهایی که تأثیرگذاری بالایی دارند یا تأثیر قابل توجهی بر بازار داخلی میگذارند، باید الزامات اضافی زیر را رعایت کنند:

- انجام ارزیابی مدل:

شامل آزمایشهای خصمانه و شبیهسازیهای مختلف برای شناسایی مشکلات احتمالی.

- ارزیابی و کاهش ریسکهای سیستمی:

شناسایی و کاهش خطرات احتمالی ناشی از استفاده از مدل.

- گزارش حوادث جدی:

اطلاعرسانی به مقامات ذیربط در مورد حوادث و مشکلات جدی که ممکن است پیش آید.

- اطمینان از امنیت سایبری:

تضمین سطح مناسب حفاظت از دادهها و سیستم در برابر تهدیدات سایبری.

۴. معیارهای طبقهبندی مدلهای با ریسک سیستمی:

قانون معیارهای خاصی برای تعیین اینکه آیا یک مدل دارای ریسک سیستمی است یا خیر، به شرح زیر تعیین میکند:

- تعداد پارامترهای مدل

- کیفیت یا اندازه مجموعه دادهها

- میزان محاسبات مورد استفاده برای آموزش مدل

- حالتهای ورودی و خروجی مدل

- معیارها و ارزیابیهای قابلیتهای مدل

- تأثیر بر بازار داخلی

- تعداد کاربران ثبتشده

۵. کدهای رفتاری:

قانون به تدوین کدهای رفتاری برای اجرای مؤثر الزامات مربوط به مدلهای هوش مصنوعی عمومی تشویق میکند. این کدها میتوانند شامل راهنماها و شیوهنامههای اجرایی برای رعایت الزامات قانونی باشند.

۶. استثنائات برای مدلهای منبع باز:

مدلهایی که تحت مجوز منبع باز منتشر میشوند و پارامترها و معماری آنها بهصورت عمومی در دسترس است، از برخی الزامات معاف هستند، مگر اینکه دارای ریسک سیستمی باشند.

۷. نظارت و اجرا:

کمیسیون اروپا دارای اختیارات انحصاری برای نظارت و اجرای مقررات مربوط به مدلهای هوش مصنوعی عمومی است. این شامل قدرت درخواست اطلاعات، انجام ارزیابیها و اعمال جریمههای لازم میشود.

۸. همکاری در طول زنجیره ارزش:

ارائهدهندگان مدلهای هوش مصنوعی عمومی باید با ارائهدهندگان سیستمهای هوش مصنوعی که از مدلهای آنها استفاده میکنند، همکاری کنند تا اطمینان حاصل شود که الزامات قانونی رعایت میشود.

این مقررات بهمنظور اطمینان از توسعه و استفاده مسئولانه و شفاف مدلهای هوش مصنوعی عمومی وضع شدهاند، در حالی که همچنان فضایی برای نوآوری در این حوزه فراهم میآورند.

تعهدات شفافیت در قانون هوش مصنوعی اتحادیه اروپا

۱. اطلاعرسانی به کاربران:

تمام سیستمهای هوش مصنوعی که با افراد تعامل مستقیم دارند باید به گونهای طراحی شوند که کاربران را مطلع کنند که با یک سیستم هوش مصنوعی در حال تعامل هستند، مگر اینکه این موضوع از نظر یک فرد معقول و آگاه واضح باشد.

۲. شفافیت در مورد سیستمهای تشخیص احساسات و طبقهبندی بیومتریک:

افراد باید از اینکه در معرض سیستمهای تشخیص احساسات یا طبقهبندی بیومتریک قرار گرفتهاند، آگاه شوند.

۳. شفافیت در مورد محتوای مصنوعی (دیپفیکها):

استفادهکنندگان از سیستمهای هوش مصنوعی که تصاویر، صدا یا ویدئوهای مشابه با افراد، اشیاء یا صحنههای واقعی تولید میکنند، باید افشا کنند که محتوای تولید شده بهصورت مصنوعی ایجاد یا دستکاری شده است.

۴. شفافیت در مورد محتوای متنی تولید شده توسط هوش مصنوعی:

در مواردی که متن تولید شده توسط هوش مصنوعی با هدف اطلاعرسانی به عموم در مورد مسائل مورد علاقه عمومی منتشر میشود، باید افشا شود که متن بهصورت مصنوعی تولید یا دستکاری شده است، مگر اینکه محتوا تحت بررسی انسانی یا کنترل سردبیری قرار گرفته باشد.

۵. علامتگذاری محتواهای مصنوعی:

ارائهدهندگان سیستمهای هوش مصنوعی که محتوای مصنوعی تولید میکنند باید راهحلهای فنی برای علامتگذاری این محتوا در قالبی قابل خواندن توسط ماشین ارائه دهند.

۶. استثنائات:

- این الزامات برای سیستمهای هوش مصنوعی که بهمنظور تشخیص، پیشگیری، تحقیق یا پیگرد جرائم کیفری مجاز هستند، اعمال نمیشود، مشروط به اینکه تدابیر مناسب برای حفاظت از حقوق و آزادیهای اشخاص ثالث وجود داشته باشد.

- برای محتوای هنری، خلاقانه، طنز یا داستانی، الزامات شفافیت محدود به افشای وجود چنین محتوای تولید یا دستکاریشدهای است بهگونهای که مانع از نمایش یا لذت بردن از اثر نشود.

۷. نحوه ارائه اطلاعات:

- اطلاعات باید بهطور واضح و قابل تشخیص، حداکثر در زمان اولین تعامل یا مواجهه، ارائه شود.

- اطلاعات باید با الزامات دسترسیپذیری مطابقت داشته باشد.

۸. کدهای رفتاری:

کمیسیون اروپا میتواند تدوین کدهای رفتاری در سطح اتحادیه اروپا را برای تسهیل اجرای مؤثر تعهدات مربوط به شفافیت و برچسبگذاری محتوای مصنوعی تشویق و تسهیل کند.

۹. ارتباط با سایر قوانین:

این تعهدات شفافیت نباید بهعنوان نشانهای از قانونی بودن استفاده از سیستمهای هوش مصنوعی یا خروجی آنها تفسیر شود و بدون تعصب نسبت به سایر تعهدات شفافیت تحت قوانین اتحادیه اروپا یا ملی است.

این تعهدات شفافیت با هدف افزایش آگاهی عمومی از استفاده از هوش مصنوعی و محتوای مصنوعی طراحی شدهاند، که به نوبه خود به حفاظت از حقوق افراد و تقویت اعتماد عمومی به فناوری هوش مصنوعی کمک میکنند.

ساختار حکومتی قانون هوش مصنوعی اتحادیه اروپا

۱. هیئت اروپایی هوش مصنوعی (European Artificial Intelligence Board):

- ترکیب: شامل نمایندگان کشورهای عضو و ناظر از کمیساریای حفاظت از دادههای اروپا.

- وظایف:

- مشاوره و کمک به کمیسیون اروپا و کشورهای عضو.

- هماهنگی میان مقامات ملی صلاحیتدار.

- جمعآوری و به اشتراکگذاری تخصص فنی و نظارتی.

- ارائه توصیهها و نظرات کتبی در مورد مسائل مرتبط با اجرای قانون.

- کمک به توسعه راهنماها و استانداردهای مربوطه.

۲. دفتر هوش مصنوعی اروپا (European Artificial Intelligence Office):

- بخشی از کمیسیون اروپا:

- وظایف:

- توسعه تخصص و قابلیتهای اتحادیه اروپا در زمینه هوش مصنوعی.

- کمک به اجرای مقررات و نظارت بر سیستمهای هوش مصنوعی و مدلهای هوش مصنوعی عمومی.

- نظارت بر اجرای مقررات مربوط به مدلهای هوش مصنوعی عمومی.

۳. مقامات ملی صلاحیتدار (National Competent Authorities):

- تعریف: هر کشور عضو باید حداقل یک مقام اطلاعدهنده و یک مقام نظارت بر بازار تعیین کند.

- وظایف:

- نظارت بر اجرای قانون در سطح ملی.

- انجام ارزیابیهای انطباق.

- اجرای مقررات و اعمال جریمهها در صورت نیاز.

۴. انجمن مشورتی (Advisory Forum):

- ترکیب: نمایندگان صنعت، استارتآپها، شرکتهای کوچک و متوسط (SMEها)، دانشگاهها و جامعه مدنی.

- وظیفه: ارائه مشاوره و تخصص فنی به هیئت و کمیسیون.

۵. پنل علمی متخصصان مستقل:

- ترکیب: متخصصان مستقل با تخصص بهروز در زمینه هوش مصنوعی.

- وظایف:

- پشتیبانی از فعالیتهای اجرایی، به ویژه در مورد مدلهای هوش مصنوعی عمومی.

- ارائه هشدارهای کیفی در مورد ریسکهای سیستمی.

۶. ساختارهای پشتیبانی آزمایش هوش مصنوعی اتحادیه اروپا:

- هدف: کمک به کشورهای عضو در اجرای مؤثر قانون و فراهم کردن زیرساختهای لازم.

۷. سندباکسهای نظارتی هوش مصنوعی:

- تعریف: هر کشور عضو باید حداقل یک سندباکس نظارتی هوش مصنوعی ایجاد کند.

- هدف: تسهیل نوآوری و آزمایش سیستمهای هوش مصنوعی در یک محیط کنترلشده و آزمایشی.

۸. نقطه تماس واحد:

- تعریف: هر کشور عضو باید یک مقام نظارت بر بازار را به عنوان نقطه تماس واحد تعیین کند.

۹. همکاری بینالمللی:

- هدف: شامل مکانیزمهایی برای همکاری با مقامات صلاحیتدار کشورهای ثالث و سازمانهای بینالمللی.

۱۰. مکانیزمهای بازنگری و بهروزرسانی:

- هدف: تضمین بازنگری و بهروزرسانی منظم مقررات برای همگامی با پیشرفتهای فناوری و تغییرات محیطی.

این ساختار حکومتی چندلایه برای اطمینان از اجرای یکنواخت و مؤثر قانون در سراسر اتحادیه اروپا طراحی شده است، در حالی که انعطافپذیری لازم برای سازگاری با شرایط ملی و پیشرفتهای فناوری را فراهم میکند.